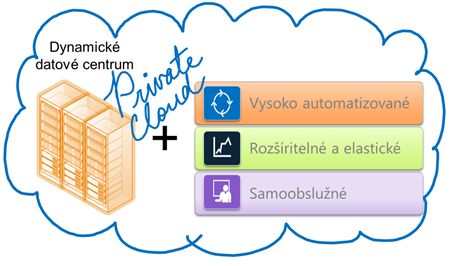

Dynamické dátové centrum je jedným zo základných pilierov privátneho cloudu. Aby ho bolo možné na privátny cloud povýšiť, je potrebné implementovať nástroje, ktoré zabezpečia aby dynamické virtuálne prostredie bolo navyše vysoko automatizované, jednoducho rozšíriteľné – elastické a samoobslužné.

Rozšírenie dynamického dátového centra na privátny cloud

Microsoft dal na adrese www.microsoft.com/ipd k dispozícii na stiahnutie súbor dokumentov pod názvom Infrastructure Planning and Design Guide Series (ďalej len IPD). Podľa metodického dokumentu Infrastructure Planning and Design Dynamic Datacenter , ktorý je súčasťou IPD je možné implementáciu dynamického dátového centra rozdeliť do piatich krokov:

- Analýza potrieb

- Návrh virtualizovaného prostredia

- Návrh softvérovej infraštruktúry

- Návrh úložiska

- Návrh sieťovej infraštruktúry

IPD v rámci Microsoft Operations Framework 4.0

Akcelerátory riešení Microsoft Solution Accelerators sú k dispozícii na: adrese www.microsoft.com/technet/SolutionAccelerators

Microsoft Operations Framework (MOF) poskytuje informácie o zladení firemných a IT požiadaviek a potrieb.

Krok 1: Analýza potrieb

Fázu analýzy potrieb je možné rozdeliť do viacerých čiastkových úloh.

Definovanie predpokladaného počiatočného zaťaženia – v tejto fáze zisťujeme, aké aplikácie a pod akými operačnými systémami budú v dynamickom dátovom centre bežať. Stanovíme požiadavky na výpočtové zdroje, teda pamäť, CPU, diskový priestor a sieť. Do úvahy berieme požiadavky na vysokú dostupnosť. V tejto fáze môžeme naraziť na prekážky, ktoré aplikácii bránia aby bežala vo virtuálnom prostredí. Zriedkavejšie to môžu byť problémy technické, no najčastejšie vás v konsolidačnom a virtualizačnom úsilí zabrzdia normatívne, alebo legislatívne požiadavky, kedy povaha aplikácie, alebo údajov s ktorými aplikácia pracuje neumožňuje prevádzkovanie v zdieľanom prostredí. V takom prípade je nutné aplikáciu ponechať na oddelenom hardvéri. V tejto etape môžete s výhodou využiť nástroj Microsoft Assessment and Planning Toolkit, ktorý je schopný uvedené informácie získať analýzou existujúceho prostredia

Zaistenie správnej metódy dosiahnutia vysokej dostupnosti pre každú aplikáciu – vysoká dostupnosť je jedným z hlavných cieľov dynamického datacentra. Avšak nie je vždy nutné implementovať redundantné komponenty na všetkých úrovniach pre dosiahnutie tohto cieľa. Ruka v ruke s vyššou redundanciou samozrejme idú hore aj náklady, ktoré však pri dvojnásobnej, prípadne až trojnásobnej redundancii nie sú dvoj, prípadne trojnásobkom, ale oveľa vyššie, nakoľko je potrebné implementovať mechanizmy na prepínanie z entity ktorá je v poruche na záložnú a to samozrejme bez prerušenia prevádzky. Preto je dôležité zamerať sa na to aké aplikácie v dynamickom dátovom centre bežia a akú dostupnosť vyžadujú. Niektoré softvérové subsystémy napríklad active directory, či DNS sú navrhnuté tak, aby boli vysoko dostupné aj bez prídavných opatrení. Pre dosiahnutie požadovanej miery dostupnosti u webových serverov môžete využiť Load Balancing, pre klasické servery Level Clustering či už na úrovni virtuálnych strojov, alebo na úrovni hostovaného prostredia. Na úrovni aplikácií je možné využiť Application-Level Fault Tolerance.

Na základe výsledkov z predchádzajúcich úloh môžete definovať celkovú veľkosť dátového centra. Je potrebné mať na zreteli, že sa jedná o počiatočné dimenzovanie. K tomu je potrebné pripočítať rezervu na predpokladaný rast a redundanciu vyplývajúcu z požadovanej dostupnosti. Dôležitou súčasťou projektu je časový plán prechodu na dynamické dátové centrum.

Dynamické dátové centrum je vo väčšine prípadov pomerne veľký projekt a význam etapy analýzy a definovania požiadaviek je v metodike podčiarknutý celkovou kontrolou na záver prvého kroku. Účelom kontroly je zabezpečenie úplnosti zoznamu aplikácií a ich správneho začlenenie. Realizácia tejto fázy spravidla prebieha formou otázok pre kompetentných vedúcich pracovníkov. V tejto fáze sa ubezpečíte, že zoznam aplikácií naozaj kompletný, že ste identifikovali aplikácie, ktoré by nemali byť virtualizované, prípadne musia bežať v izolovanom prostredí a že máte definované akceptovateľné riziko výpadku.

Krok 2: Návrh virtualizovaného prostredia

Nakoľko navrhujete dynamické dátové centrum v ktorom bude bežať virtualizované prostredie, nevyhnete sa ani návrhu hardvéru. Je potrebné definovať hardvérové konfigurácie hostiteľských serverov. A zasa sme pri otázke vysoká dostupnosť verzus náklady. Redundancie na úrovni hardvérových komponentov nie je nutná, ak bude nahradená inými prostriedkami. Následne metodika požaduje definovať nároky na sieťové pripojenie. Bude vaše prostredie využívať vyhradenú sieťovú kartu, alebo fyzickú sieť, prípadne vaše aplikačné prostredie bude izolované bez sieťového pripojenia?

Pri návrhu virtualizovaného prostredia býva dobrým pravidlom združiť aplikácie, ktoré majú podobné nároky a potreby hlavne ohľadne dostupnosti. Podobne ako v prvom kroku aj na záver druhého kroku metodika odporúča záverečnú kontrolu formou otázok pre vedúcich pracovníkov. Napríklad:

- Pokrýva navrhnutý dizajn všetky podporované scenáre použitia?

- Spĺňa sieťová infraštruktúra nároky na bezpečnosť?

Krok 3: Návrh softvérovej infraštruktúry

Prvou fázou je analýza, či je existujúca softvérová infraštruktúra dostatočná na efektívne poskytovanie požadovaných služieb a či existujúce služby majú dostatočnú úroveň vysokej dostupnosti. Je firma, alebo organizácia spokojná s aktuálnymi obchodnými procesmi a správou služieb? Je firma, alebo organizácia spokojná s ich IT podporou? Je vyžadované oddelené prostredie z dôvodov bezpečnosti alebo právnej zhody?

Následne sa dostávame k správe infraštruktúry. Ako bude spravovaná? Bude povolený prístup ku správe datacentra externým subjektom? V prípade väčšieho dátového centra Bude spravované separátnom tímom? Ďalšou úlohou v tomto kroku bude správa virtuálnych hostov. Budú spravované prostredníctvom existujúcej infraštruktúry, alebo budú mať virtuálne stroje vlastnú doménu Active Directory, Config Manager, VMM, …? Nie každý virtuálny stroj potrebuje kompletný dohľad. Týka sa to hlavne testovacích strojov.

Krok 4: Návrh úložiska

Metodika Microsoftu odporúča spolupracovať s dodávateľom na výbere najvhodnejšieho riešenia dátových úložísk. Pri voľbe počtu pevných diskov je potrebné zohľadniť nielen kapacitu, ale aj priepustnosť a spoľahlivosť. Pre zaistenie vysokej dostupnosti je potrebné využiť multipath I/O a vyhraďte port na každom switchi pre každého hostiteľa a pripojenie k úložisku. Zvážte oddelenie iSCSI prevádzky od ostatných typov IP komunikácie – okrem nárastu výkonu sa jedná aj o bezpečnostný prvok. Podobne ako na ostatných úrovniach, aj na úrovni dátových úložísk je potrebné riešiť zotavenie sa po hardvérovej chybe, v tomto prípade sa jedná o automatizovanú obnovu dát po nahradení nefunkčného hardvéru. S úložiskom sa viaže aj zálohovanie. Je potrebné počítať s dostatočnou kapacitou pre zálohy. Väčšinou sa využívajú kópie virtuálnych pevných diskov alebo VSS snapshoty. Dobrým pomocníkom pri plánovaní úložiska je Infrastructure Planning and Design guide for System Center Data Protection Manager.

Krok 5: Návrh sieťovej infraštruktúry

V tomto kroku sa navrhuje architektúra sieťových prepínačov. Podľa údajov z predchádzajúcich krokov sa s dostatočnou rezervou definuje počet portov potrebných pre jednotlivé siete. V prípade potreby sa pokračuje návrhom hardvérových Load Balancerov, ktoré rozkladajú sieťové požiadavky na dva a viac cieľov. Nasleduje návrh firewallov pre oddelenie siete dátového centra od okolitého sveta pre zvýšenie bezpečnosti.

Dynamické dátové centrum verzus privátny cloud

Virtualizácia umožní podstatne zvýšiť vyťaženosť existujúcej infraštruktúry, konsolidované prostredie s možnosťou vypínania nepoužívaných serverov, prípadne procesorových jadier prispieva k dosť výrazným úsporám energie. Vzhľadom na vyššiu vyťaženosť je možné znížiť počet inštalovaných fyzických serverov. Stále však zostáva významný “brzdiaci” faktor a tým je nutnosť manuálnej správy celej infraštruktúry. Administrátor musí spravovať systém, prideľovať zdroje pre virtuálne počítače a vykonávať s nimi ďalšie operácie aby ich bolo možné využiť pre aplikačné prostredie.

Naproti tomu privátny cloud by sme mohli charakterizovať ako virtualizované prostredie ku ktorému pridáme automatizáciu vnútorných procesov, zabezpečíme vysokú škálovateľnosť a elasticitu. Dôležitým atribútom, ktorý rozlišuje privátny cloud od virtualizovaného dátového centra je samoobslužnosť. Používatelia majú možnosť v rámci pridelenej kvóty vytvárať si virtuálne počítače

Rozdiel medzi privátnym cloudom a virtualizovaným dátovým centrom výstižne definuje nasledujúce priradenie:

Privátny cloud =

virtualizácia + vysoký stupeň automatizácie + škálovateľnosť a elasticita + samoobslužnosť

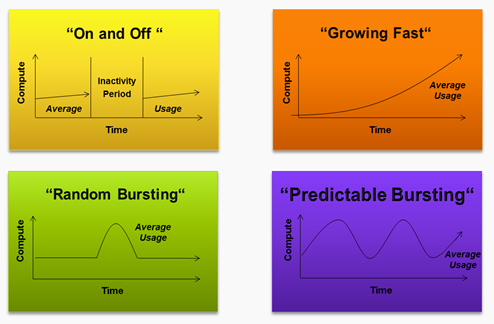

Typické scenáre pre využitie výhod privátneho cloudu

Hyper-V Cloud pre budovanie privátnych cloudov

Technológia virtualizácie hrá stále dôležitejšiu úlohu na všetkých úrovniach IT – od stolových počítačov až po dátové centrá. Stále viac organizácií využíva virtualizáciu na správu úloh dôležitých pre chod firmy a konsolidácia serverov im prináša výhodu v podobe úspory nákladov. Množstvo organizácií plánuje rozšíriť virtualizáciu na podporu základných funkcií, ako je napríklad zaistenie nepretržitého chodu organizácie, zotavenie po havárii, testovanie a vývoj a vzdialená správa.

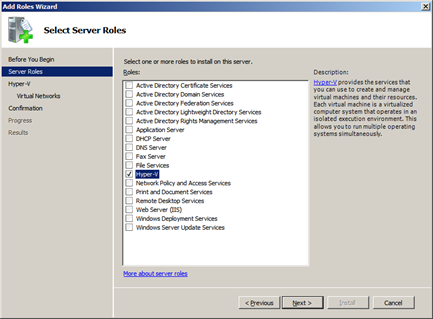

Hypervízor Hyper-V

Aby mohli zákazníci začať využívať virtualizáciu jednoduchšie, vyvinula spoločnosť Microsoft novú generáciu riešení pre virtualizáciu serverov, ktorá je jednou z rolí operačného systému Windows Server 2008. Hyper-V je spoľahlivá a škálovateľná virtualizačná platforma s balíkom integrovaných nástrojov pre správu fyzických aj virtuálnych prostriedkov. Spoločnosť Microsoft navyše v spolupráci so svojimi partnermi zabezpečuje komplexnú podporu umožňujúcu nasadzovať aplikácie do virtuálneho prostredia veľmi jednoducho a spoľahlivo.

Od verzie Windows Server 2008 je mikrokernelický hypervízor Hyper-V j integrálnou súčasťou operačného systému. Nové verzie, teda Windows Server 2008 R2 a Windows Server 8 prinášajú zakaždým aj novú verziu Hyper-V.

Hypervízor je tenká vysoko optimalizovaná softvérová vrstva bežiaca priamo nad hardvérom, ktorá priamo podporuje beh viacerých virtuálnych operačných systémov súčasne na hardvérovom serveri.

Inými slovami – vrstva hypervízora alokuje a distribuuje kapacitu viacprocesorového servera pre jednotlivé virtuálne stroje a ich multithreadové aplikácie.

Hyper-V pomáha dosiahnuť čo najefektívnejšie využitie investícií do serverového hardvéru vďaka konsolidácii viacerých serverových rolí prevádzkovaných ako samostatné virtuálne počítače v jedinom fyzickom počítači. Pomáha tiež efektívne prevádzkovať niekoľko rôznych operačných systémov (Windows, Linux a ďalšie) paralelne na jednom serveri a plne využívať výkon výpočtovej platformy x64.

Stručne vymenujeme hlavné výhody:

- Vyššia dostupnosť virtualizovaných dátových centier vďaka významným vylepšením, ako je napríklad migrácia počas prevádzky

- Lepšia správa virtualizovaných dátových centier vďaka integrácii prostredia PowerShell a riešenia System Center

- Vyšší výkon

pre virtuálne počítače Hyper-V vďaka podpore až 64 logických procesorov a režimu kompatibility procesorov - Vyšší výkon virtuálnej siete vďaka novým sieťovým technológiám

- Jednoduchšie nasadenie fyzických a virtuálnych počítačov vďaka vylepšenej podpore súborov VHD

Rolu Hyper-V môžete pridať v kroku 3 Customize This Server inicializačného dialógu, prípadne v priečinku Roles Summary v hlavnom okne Server Managera

Po nainštalovaní role Hypr-V sa operačný systém “zvirtualizuje”, teda podsunie sa pod neho virtualizačná vrstva.

Hyper-V na platforme Windows Server 2008 R2 je zameraný na tri kľúčové oblasti, ktoré sú potrebné pre budovanie dynamických virtuálnych dátových centier:

- Zvýšenie spoľahlivosti

- Zdokonalenie a zjednodušenie administrácie

- Zjednodušenie prenosu pre fyzické a virtuálne stroje prostredníctvom vhd súborov

Vyššia flexibilita

Technológia Hyper-V ako súčasť systému Windows Server 2008 R2 poskytuje vysokú dostupnosť a možnosť dynamickej migrácie pri plánovaných aj neplánovaných výpadkoch prostredníctvom funkcie Migrácia počas prevádzky (Live Migration) a klasteringu s podporou prevzatia služieb pri zlyhaní s využitím širokej ponuky hostiteľského hardvéru podporujúceho technológiu Hyper-V, a prináša tak flexibilitu dynamickej IT infraštruktúry. Pomocou technológie Hyper-V môžu zákazníci využívať rovnaký balík nástrojov pre správu fyzických aj virtuálnych prostriedkov. Je možné ju jednoducho integrovať do IT infraštruktúry zákazníkov, ktorí môžu využívať súčasné procesy a nástroje pre opravy, zaisťovanie služieb, správu a podporu. môžu zákazníci virtualizovať systémy úplne bez obáv.

Vyšší výkon

Technológia Hyper-V využíva niekoľko nových procesorových a sieťových technológií a riešení na správu pamäte ponúkaných partnerskými nástrojmi a obsiahnutých v systéme Windows Server 2008 R2 a zvyšuje tak celkový výkon hostiteľských a virtuálnych počítačov. Ak sprístupníme virtuálnym počítačom výkonné technológie ako viacjadrové procesory, zrýchlený prístup k diskom a podpora väčšej pamäte, zlepší technológia Hyper-V škálovateľnosť a výkon celej virtualizovanej platformy.

Lepšia škálovateľnosť

Technológia Hyper-V ponúka lepšiu spoľahlivosť a väčšie možnosti škálovateľnosti, čo vám umožní virtualizovať vašu infraštruktúru. Je vybavená hypervízorom v podobe tzv. mikrojadra, ktorý obsahuje len najnutnejšie funkcie pre virtualizáciu, takže je len minimálne vystavený prípadným útokom. Navyše je k dispozícii ako rola Server Core. Vďaka podpore až 64 logických procesorov, parkovania procesorových jadier a riadenia spotreby procesorov môže technológia Hyper-V zvládať tie najnáročnejšie úlohy a zároveň znižovať spotrebu elektriny serverov.

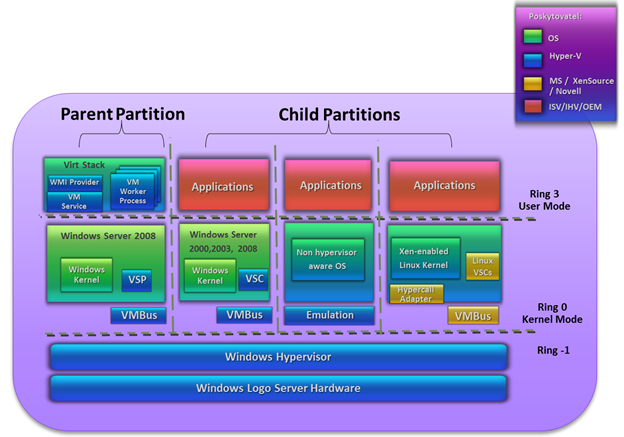

Architektúra využívajúca hypervízory

Vďaka architektúre s hypervízorom v podobe mikrojadra ponúka technológia Hyper-V bezpečnejší a spoľahlivejší základ pre prevádzkovanie virtuálnych počítačov. Tento minimalizovaný hypervízor neobsahuje ovládače – ako hostiteľ ovládačov sa používa parent partition. Spoločne s novým modelom zdieľania vstupno-výstupných operácií tak technológia Hyper-V poskytuje podstatne bezpečnejšiu architektúru. Technológia Hyper-V umožňuje využívať nové a rozšírené funkcie a výhody, napríklad podporu symetrického multiprocesingu (SMP), riešenia pre dynamické úložiská, podporu až 64 GB pamäte na jeden virtuálny počítač a možnosť minimálnej inštalácie, Server Core.

Architektúra Hyper – V

Výhody virtualizovaného prostredia na báze Hyper-V

- Nižšie náklady na hardvér, údržbu a zamestnancov vďaka konsolidácii serverov

- Zjednodušenie a automatizácia vývoja, nasadenia a prevádzky zložitých systémov s integrovanou správou

- Zlepšenie flexibility IT prostredí prostredníctvom konsolidácie heterogénnych úloh

- Virtualizácia úloh infraštruktúry v prostredí Server Core tak, aby boli spracovávané v najspoľahlivejších konfiguráciách

- Využívanie možností vysokej dostupnosti nástrojov pre správu produktu System Center a systému Windows Server, ktoré umožňujú lepšie plniť požiadavky vyplývajúce z prísnych metrík pre odozvu

- Využívanie komplexnej podpory zo strany spoločnosti Microsoft a širokej škály riešení od partnerov spoločnosti Microsoft

Hyper-V Cloud

Názov Hyper-V Cloud zapuzdruje sadu programov nástrojov a metodík, ktorá umožní zákazníkom a partnerom rýchlo a efektívne implementovať privátne cloudy na báze virtualizačnej technológie Hyper-V a naplno využiť výhody cloud-computingu, hlavne vysokú flexibilitu, možnosť rýchleho nasadenia a samozrejme nižšie náklady, to všetko pri zachovaní kontroly nad fyzickou infraštruktúrou a bezpečnostnou politikou. Sada programov a iniciatív so spoločným názvom Hyper-V Cloud pomáha firmám a organizáciám pomáha:

Vybudovať svoj vlastný privátny cloud s pomocou príručiek popisujúcich nasadenie riešenia Hyper-V Cloud prostredníctvom partnerov pre riešenie Hyper-V Cloud

Získať vopred overené konfigurácie privátneho cloudu od partnerov OEM v programe Hyper-V Cloud Fast Track. Partneri v programe Hyper-V Cloud Fast Track v spolupráci so spoločnosťou Microsoft pripravili ponuky, ktoré spájajú hardware a software na základe referenčnej architektúry pre vytvorenie privátneho cloudu.

Nájsť poskytovateľa služieb v programe poskytovateľov služieb Hyper-V Cloud, ktorý pre nich môže hosťovať dedikovaný privátne cloud

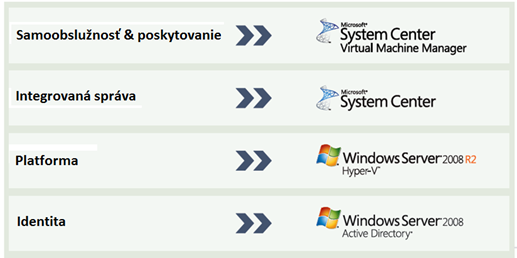

Privátny cloud beží na technológiách, ktoré už väčšina firiem má k dispozícii. Pre správu identít sa využíva Active Directory voči nemu sa identifikujú používatelia, ktorí chcú využívať služieb privátneho cloudu. Nad virtualizačnou platformou sú situované vrstvy pre integrovanú správu a samoobslužnosť. Táto je voči používateľom dosiahnutá prostredníctvom samoobslužného intranetového portálu.

Základné piliere Hyper-V Cloud

Z pohľadu zákazníka je veľmi dôležitý výber zo širokej palety predkonfigurovaných konfigurácií. Preto sa k Microsoftu pridalo niekoľko kľúčových partnerov (IBM, NEC, HP, Hitachi, Fujitsu a Dell), ktorí dodávajú predkonfigurované riešenia na báze Hyper-V Cloud. Na populárnych serveroch HP Blade system Matrix sa privátne cloudy vytvárajú v rámci strategického partnerstva HP Cloud Foundation For Hyper-V s využitím Microsoft System Center a Windows Server 2008 R2 Hyper-V. HP taktiež ponúka program HP CloudStart pre Hyper-V, kde zaručuje klientom vytvorenie plne funkčného privátneho cloud prostredia do 30 dní.

Súčasťou Hyper-V Cloud sú aj komponenty:

- Hyper-V Cloud Service Provider Program pre poskytovanie cloudových služieb.

- Hyper-V Cloud Deployment Guides – súbor nástrojov a postupov pre vytváranie privátnych cloudov pri využití existujúcej infraštruktúry

- Hyper-V Cloud Accelerate – metodika pre zavádzanie cloudových riešení.

Live Migration prostredníctvom technológie Cluster Shared Volumes

Live Migration na platforme Windows Server 2008 R2využíva novú črtu Cluster Shared Volumes (CSV) cez Failover Clustering. CSV umožňuje vytvorenie viacerých uzlov pre ten istý failover cluster. Tieto uzly pristupujú súčasne na ten istý LUN (logical unit number).

Princíp fungovania Cluster Shared Volumes

Každý virtuálny stroj vlastní svoj LUN, no VHD súbory pre každý virtuálny stroj sú uložené v tom istom CSV.

CSV architektúra má implementovaný mechanizmus dynamického presmerovania I/O (v originálnej terminológii dynamic I/O redirection). Obrázok ukazuje presmerovanie v prípade zlyhania SAN konektivity

Presmerovanie v prípade poruchy siete

V prípade poruchy uzla sa presunú vlastnícke práva k CSV na funkčný uzol, bez výpadku služieb.

Presmerovanie v prípade poruchy uzla clustera

Pri Live Migration sú klienti stále pripojený a môžu využívať služby virtuálnych serverov. Aby mohla byť takáto migrácia realizovaná, najskôr sa vytvorí cieľový virtuálny stroj a zosynchronizuje sa obsah pamäti. Klienti stále pristupujú k pôvodnému virtuálnemu stroju. Po synchronizácii pamäti sa klienti presunú na virtuálny stroj na cieľovom uzle.

Live Migration – vytvorenie virtuálneho stroja na cieľovom uzle a synchronizácia pamäti

Live Migration – ukončenie migrácie, klienti pristupujú k virtuálnym strojom na cieľovom uzle

Príručky pre nasadenie riešenia Hyper-V Cloud

Príručky popisujúce nasadenie riešenia Hyper-V Cloud prinášajú sadu osvedčených postupov vychádzajúcich z rámca vytvoreného divíziou Microsoft Consulting Services. Sú navrhnuté tak, aby organizáciám pomohli pri nasadení riešení pre privátny cloud s použitím produktov Windows Server 2008 R2 Hyper-V a System Center Virtual Machine Manager 2008 R2

K dispozícii sú príručky

- HVC_Deployment_Guides_Module_1-Architecture.pdf

- HVC_Deployment_Guides_Module_2-Deployment.pdf

- HVC_Deployment_Guides_Module_3-Operations.pdf

- HVCDeployment GuidesModule4-DeploymentValidationWorkbook

- HVCDeploymentGuidesModule5-ProjectPlanTemplate.mpp

Odkazy na ich stiahnutie nájdete napríklad na: http://virtualisationandmanagement.wordpress.com/2010/11/18/private-cloud-solutions-hyper-v-cloud-deployment-guides/

Príručky s osvedčenými metodikami umožňujú rýchlejšie nasadenie vďaka poskytnutiu osvedčených postupov na plánovanie a realizáciu riešení pre privátne cloud založeného na virtualizačných technológiách spoločnosti Microsoft. Umožňujú zníženie nákladov na školenia vďaka poskytnutiu metodík pre uskutočnenie scenárov virtualizácie serverov. Taktiež umožnia zníženie rizík vďaka poskytnutia príkladov skutočných problémov a riešení, s ktorými sa stretli architekti a konzultanti spoločnosti Microsoft